Special Feature

責任あるビジネスのために 理解広がる「AI倫理」の最新動向

2022/09/19 09:00

週刊BCN 2022年09月19日vol.1939掲載

ビジネス、生活におけるさまざまなシーンでAI、機械学習技術の利用が進み、AIが社会インフラの一部となりつつある。そしてAIの普及と共に重視され始めたのが、倫理の問題だ。AIの利用には学習するデータや活用の適切な範囲、AIが判断する基準や最終的な決定に誰が責任を取るかなどをあらかじめ考慮しなければならない。倫理問題を解決できなければ、AIが企業ブランドを傷つけ、ビジネスにマイナスの影響すら与えかねない。AI倫理の最新動向について、国内外のベンダーの対応状況から明らかにしたい。

(取材・文/谷川耕一 編集/藤岡 堯)

AIは現実から学習を深める以上、用いるデータによっては、判断にバイアスが入る懸念がある。例えば、人種や性別的に偏りが含まれるデータが利用されれば、導き出される結果にも偏りが生じる。AIを開発・利用する事業者は、バイアスのかかった結果を出さないようにし、AIの判断に対する責任の所在をはっきりさせなければ、信頼を得ることはできない。

AI倫理の問題に対処するために、各国ではガイドラインを公表し規制や統制をする動きがある。今後、経営層は自社製品やサービスが、それらガイドラインに沿っているかはもちろん、取引先やパートナー企業などが準拠できているかも気にかける必要がある。

日本では経済産業省が2018年6月に「AI・データの利用に関する契約ガイドライン」を策定した(19年12月に改訂)。これは罰則などを伴わないが、欧州で検討されている「EU AI Act」では多額の賠償金を伴う規制の策定が進んでおり、このような動きもAI倫理を重視することにつながる。

Azure AIの一つに、オリジナルの音源とほぼ同じ合成音声を作成できる「Custom Neural Voice」があり、顧客とのやり取りで利用している活用事例もある。この機能は精度が高いほど、不適切ななりすましや聞き手を欺くために利用される懸念もある。マイクロソフトでは新しいResponsible AI Standardに基づき、この技術を階層的管理フレームワークに移行し、顧客からのアクセスを制限して許容できるユースケースを事前定義し悪用を防ぐようにしている。

顔認証サービスである「Azure Face Service」も同様の統制を適用した。既存顧客への移行期間を経た後にサービスへのアクセスを厳格に管理された顧客とパートナーに限定し、あらかじめ定義されたユースケース範囲内に絞り込み、サービスに組み込まれた技術的コントロールを活用する。

さらにResponsible AI Standardの基準に適合させるために、感情、性別、年齢、笑顔、髭や髪型、化粧などのアイデンティティ属性を推論する機能の廃止も決めた。成果が出ており、ユーザーから一定の評価を得ているサービスであっても、マイクロソフトではAI倫理の観点から利用を大きく制限するとの判断を下したのだ。

AIを重視する企業は、高い業績を生んでいる。業績を伸ばすためにAIの利用が増えれば、経営者もAI活用が他社に対する優位性となると考える。その上でAI倫理に対する厳格化を求める声が消費者や株主などから上がっており、外部環境からも経営者はAI倫理が経営戦略上重要なものと認識せざるを得ない。

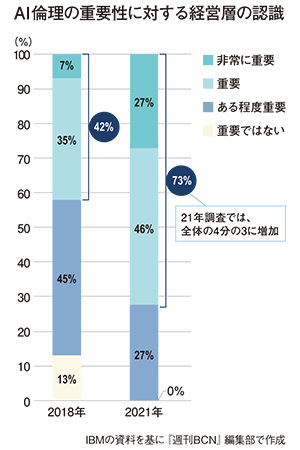

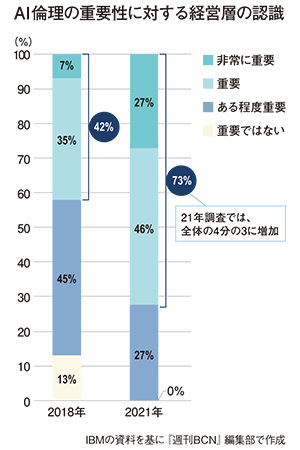

IBMの調査でも、18年に42%だったAI倫理が非常に重要、または重要だとする回答の合計が、21年には73%に増えた(図参照)。この結果からもAI倫理は認知、原則を策定する段階から、ガイドラインなどを活用した実践段階に入っていると判断できる。とはいえ、実際の取り組みはそれほど進んでいない現実もある。経営層の50~60%ほどがAI倫理原則に賛同しているが、実践できているとの回答は10~20%にとどまる。進まない原因の一つは、AIを推進するチームそのものの多様化など、ダイバーシティの低さがある。女性が少ないなど社内のダイバーシティが進んでいないため、組織そのものにバイアスが存在することが影響しているようだ。

一方、IBMではAI倫理の推進役がビジネスリーダー主導となってきたことをポジティブに捉えている。18年にはビジネスリーダーが主導しているとの回答は15%しかなかったが、21年には80%が事業部のリーダーがAI倫理に「自分ゴト」として取り組むべきだと考えている。これは意欲と実践のギャップを埋めるのに、プラスで働くと考えられる。

IBM自身は、18年に信頼と透明性に関する原則を公表し、その中でAIの目的は人間の知性を補うこと、データと知見はその作成者に帰属すること、AIを含む新しい技術は透明で説明可能でなければならないことの3点をうたっている。

同年には、設計者や開発者のために実践的なガイドラインも発行しており、ここではAIの設計開発に携わる人は結果に対し説明できる責任を持つこと、AIの価値を届けるユーザーが持つ規範や価値観を捉え設計をすること、AIの決定プロセスが人に理解できるものであること、偏見を最小限に抑え公平性があるよう設計すること、ユーザーデータの保護の観点を持ちAIを設計することの五つのポイントが示されている。

IBMではAIの倫理、ガバナンス体制を18年からつくり、一番上にプライバシーアドバイザリー委員会、その下にAI倫理委員会を設置している。ここでAI倫理のビジョン、戦略、見解を策定し、リスクの特定、審査、承認などを実施し、各事業部のAI倫理担当者をサポートし事業部内で説明責任を取れるようにしている。その上で全社員向けのAI倫理に関する研修も展開している。

顧客向けには、AIモデルの検証テストをモデルのライフサイクル全体で自動化する「IBM Watson OpenScale」を提供している。これにより、AI倫理の観点で説明性や公平性など、モデルの運用を継続的に監視し是正をリコメンドできる。他社のAIサービスも管理対象にすることが可能だ。影響の評価方式を開発・無償公開

22年2月、富士通はAI倫理ガイドラインに基づいてAIシステムの倫理上の影響を評価する方式を開発し、その手順書や適用例と共に無償公開を開始した。富士通も社会のAI倫理への認識は広がっており、それに対処しなければならないとの気運が醸成されつつあるとみる。

一方、AI倫理にどのように対処すればよいか、その方策はまだ確立していない。AIを提供、利用する際に直接的に人が関与しない場合や、利用するデータに保護属性がない場合などには、AI倫理への対処は必要ないと考える人もいる。そのため富士通では、同社の顧客などに対し、どのようなAI倫理の対応を行えばよいかを提案しようとしている。この影響評価方式の公開も、手段の一つと言える。

富士通が公開したAIシステムの倫理上の影響を評価する方式は、既に明文化されているガイドラインや規制文書に基づき、対象とするAIシステムの特質、特性に合わせたチェック項目を網羅的に生成できる。チェック項目は恣意性や主観性を排した必要十分なもので、各チェック項目はガイドラインのどこに対応する項目であるか、AIシステムのどこで何を行う必要があるかを示すことができる。企画段階から運用段階に至るAIのライフサイクルに合わせ、各フェーズに応じた影響評価を行え、事前にAI倫理的なリスクを考慮することが可能だ。

2月のドラフト版公開以降、まずは富士通社内で評価方式を社内標準のAI開発プロセスに組み込み、順次、新規適用を進めている。社外の企業や大学から問い合わせがあり、AI倫理体制への組み込みの検討などが始まっているほか、講演などを通じ賛同する顧客やパートナーを募り、実証の検討なども進む。検証、実証の結果を反映させ、22年度中に正式版のリリースを予定する。

富士通としては、AI倫理評価のための技術領域において、さまざまな方式が乱立することを防ぎたいとの考えだ。そのために方向性を合わせることを目的に評価方式、手順書、適用例を公開している。AI倫理リスクマネジメント、アセスメントを必須とする素地をつくることに共感してもらえるパートナーを求めており、パートナーと共にフレームワークの強化、拡張を図り、さまざまなユースケースを一緒に提供することにも期待している。

現段階ではAI倫理のためにどのような技術を採用するかよりも、自社の中でしっかりとAI倫理に対応する体制をつくり、全社規模でAI倫理に対する理解を深めることが先決だろう。組織全体に浸透すれば、自ずと取り組むべきことが見え、そのためのパートナーも明らかになるはずだ。その上で組織のダイバーシティの向上など、AIの範囲だけでなく企業倫理という大きな枠組みの中にAI倫理が存在することにも、あらためて立ち返る必要がありそうだ。

(取材・文/谷川耕一 編集/藤岡 堯)

AIは現実から学習を深める以上、用いるデータによっては、判断にバイアスが入る懸念がある。例えば、人種や性別的に偏りが含まれるデータが利用されれば、導き出される結果にも偏りが生じる。AIを開発・利用する事業者は、バイアスのかかった結果を出さないようにし、AIの判断に対する責任の所在をはっきりさせなければ、信頼を得ることはできない。

AI倫理の問題に対処するために、各国ではガイドラインを公表し規制や統制をする動きがある。今後、経営層は自社製品やサービスが、それらガイドラインに沿っているかはもちろん、取引先やパートナー企業などが準拠できているかも気にかける必要がある。

日本では経済産業省が2018年6月に「AI・データの利用に関する契約ガイドライン」を策定した(19年12月に改訂)。これは罰則などを伴わないが、欧州で検討されている「EU AI Act」では多額の賠償金を伴う規制の策定が進んでおり、このような動きもAI倫理を重視することにつながる。

既存サービスの利用を制限 米Microsoft

22年6月、米Microsoft(マイクロソフト)はAIシステムの開発基準フレームワーク「Responsible AI Standard」の第2版を公表した。最初のバージョンは19年に社内公開され、同社の製品やサービスに内容が反映されてきた。この基準は、社会から信頼されるAIシステムをどのように構築すべきかという点に対して、マイクロソフトの考え方を示すものだ。Azure AIの一つに、オリジナルの音源とほぼ同じ合成音声を作成できる「Custom Neural Voice」があり、顧客とのやり取りで利用している活用事例もある。この機能は精度が高いほど、不適切ななりすましや聞き手を欺くために利用される懸念もある。マイクロソフトでは新しいResponsible AI Standardに基づき、この技術を階層的管理フレームワークに移行し、顧客からのアクセスを制限して許容できるユースケースを事前定義し悪用を防ぐようにしている。

顔認証サービスである「Azure Face Service」も同様の統制を適用した。既存顧客への移行期間を経た後にサービスへのアクセスを厳格に管理された顧客とパートナーに限定し、あらかじめ定義されたユースケース範囲内に絞り込み、サービスに組み込まれた技術的コントロールを活用する。

さらにResponsible AI Standardの基準に適合させるために、感情、性別、年齢、笑顔、髭や髪型、化粧などのアイデンティティ属性を推論する機能の廃止も決めた。成果が出ており、ユーザーから一定の評価を得ているサービスであっても、マイクロソフトではAI倫理の観点から利用を大きく制限するとの判断を下したのだ。

ビジネス系リーダーが実践主導へ 米IBMの調査

22年6月、米IBMは企業がAI倫理にどのように取り組んでいるかの調査レポート(21年版)を公表した。IBMのシンクタンクであるIBM Institute for Business Valueが、世界22カ国の約1200人の経営層を対象に調査したもので、AI倫理が実践段階に入ったこと、一方で企業のAI倫理に対する意欲と実際の行動には大きな隔たりがあること、そしてAI倫理の推進役がIT部門などの技術系リーダー中心からビジネス系のリーダーに変わってきていることがポイントとして挙げられている。AIを重視する企業は、高い業績を生んでいる。業績を伸ばすためにAIの利用が増えれば、経営者もAI活用が他社に対する優位性となると考える。その上でAI倫理に対する厳格化を求める声が消費者や株主などから上がっており、外部環境からも経営者はAI倫理が経営戦略上重要なものと認識せざるを得ない。

IBMの調査でも、18年に42%だったAI倫理が非常に重要、または重要だとする回答の合計が、21年には73%に増えた(図参照)。この結果からもAI倫理は認知、原則を策定する段階から、ガイドラインなどを活用した実践段階に入っていると判断できる。とはいえ、実際の取り組みはそれほど進んでいない現実もある。経営層の50~60%ほどがAI倫理原則に賛同しているが、実践できているとの回答は10~20%にとどまる。進まない原因の一つは、AIを推進するチームそのものの多様化など、ダイバーシティの低さがある。女性が少ないなど社内のダイバーシティが進んでいないため、組織そのものにバイアスが存在することが影響しているようだ。

一方、IBMではAI倫理の推進役がビジネスリーダー主導となってきたことをポジティブに捉えている。18年にはビジネスリーダーが主導しているとの回答は15%しかなかったが、21年には80%が事業部のリーダーがAI倫理に「自分ゴト」として取り組むべきだと考えている。これは意欲と実践のギャップを埋めるのに、プラスで働くと考えられる。

IBM自身は、18年に信頼と透明性に関する原則を公表し、その中でAIの目的は人間の知性を補うこと、データと知見はその作成者に帰属すること、AIを含む新しい技術は透明で説明可能でなければならないことの3点をうたっている。

同年には、設計者や開発者のために実践的なガイドラインも発行しており、ここではAIの設計開発に携わる人は結果に対し説明できる責任を持つこと、AIの価値を届けるユーザーが持つ規範や価値観を捉え設計をすること、AIの決定プロセスが人に理解できるものであること、偏見を最小限に抑え公平性があるよう設計すること、ユーザーデータの保護の観点を持ちAIを設計することの五つのポイントが示されている。

IBMではAIの倫理、ガバナンス体制を18年からつくり、一番上にプライバシーアドバイザリー委員会、その下にAI倫理委員会を設置している。ここでAI倫理のビジョン、戦略、見解を策定し、リスクの特定、審査、承認などを実施し、各事業部のAI倫理担当者をサポートし事業部内で説明責任を取れるようにしている。その上で全社員向けのAI倫理に関する研修も展開している。

顧客向けには、AIモデルの検証テストをモデルのライフサイクル全体で自動化する「IBM Watson OpenScale」を提供している。これにより、AI倫理の観点で説明性や公平性など、モデルの運用を継続的に監視し是正をリコメンドできる。他社のAIサービスも管理対象にすることが可能だ。

影響の評価方式を開発・無償公開

富士通

22年2月、富士通はAI倫理ガイドラインに基づいてAIシステムの倫理上の影響を評価する方式を開発し、その手順書や適用例と共に無償公開を開始した。富士通も社会のAI倫理への認識は広がっており、それに対処しなければならないとの気運が醸成されつつあるとみる。一方、AI倫理にどのように対処すればよいか、その方策はまだ確立していない。AIを提供、利用する際に直接的に人が関与しない場合や、利用するデータに保護属性がない場合などには、AI倫理への対処は必要ないと考える人もいる。そのため富士通では、同社の顧客などに対し、どのようなAI倫理の対応を行えばよいかを提案しようとしている。この影響評価方式の公開も、手段の一つと言える。

富士通が公開したAIシステムの倫理上の影響を評価する方式は、既に明文化されているガイドラインや規制文書に基づき、対象とするAIシステムの特質、特性に合わせたチェック項目を網羅的に生成できる。チェック項目は恣意性や主観性を排した必要十分なもので、各チェック項目はガイドラインのどこに対応する項目であるか、AIシステムのどこで何を行う必要があるかを示すことができる。企画段階から運用段階に至るAIのライフサイクルに合わせ、各フェーズに応じた影響評価を行え、事前にAI倫理的なリスクを考慮することが可能だ。

2月のドラフト版公開以降、まずは富士通社内で評価方式を社内標準のAI開発プロセスに組み込み、順次、新規適用を進めている。社外の企業や大学から問い合わせがあり、AI倫理体制への組み込みの検討などが始まっているほか、講演などを通じ賛同する顧客やパートナーを募り、実証の検討なども進む。検証、実証の結果を反映させ、22年度中に正式版のリリースを予定する。

富士通としては、AI倫理評価のための技術領域において、さまざまな方式が乱立することを防ぎたいとの考えだ。そのために方向性を合わせることを目的に評価方式、手順書、適用例を公開している。AI倫理リスクマネジメント、アセスメントを必須とする素地をつくることに共感してもらえるパートナーを求めており、パートナーと共にフレームワークの強化、拡張を図り、さまざまなユースケースを一緒に提供することにも期待している。

現段階ではAI倫理のためにどのような技術を採用するかよりも、自社の中でしっかりとAI倫理に対応する体制をつくり、全社規模でAI倫理に対する理解を深めることが先決だろう。組織全体に浸透すれば、自ずと取り組むべきことが見え、そのためのパートナーも明らかになるはずだ。その上で組織のダイバーシティの向上など、AIの範囲だけでなく企業倫理という大きな枠組みの中にAI倫理が存在することにも、あらためて立ち返る必要がありそうだ。

ビジネス、生活におけるさまざまなシーンでAI、機械学習技術の利用が進み、AIが社会インフラの一部となりつつある。そしてAIの普及と共に重視され始めたのが、倫理の問題だ。AIの利用には学習するデータや活用の適切な範囲、AIが判断する基準や最終的な決定に誰が責任を取るかなどをあらかじめ考慮しなければならない。倫理問題を解決できなければ、AIが企業ブランドを傷つけ、ビジネスにマイナスの影響すら与えかねない。AI倫理の最新動向について、国内外のベンダーの対応状況から明らかにしたい。

(取材・文/谷川耕一 編集/藤岡 堯)

AIは現実から学習を深める以上、用いるデータによっては、判断にバイアスが入る懸念がある。例えば、人種や性別的に偏りが含まれるデータが利用されれば、導き出される結果にも偏りが生じる。AIを開発・利用する事業者は、バイアスのかかった結果を出さないようにし、AIの判断に対する責任の所在をはっきりさせなければ、信頼を得ることはできない。

AI倫理の問題に対処するために、各国ではガイドラインを公表し規制や統制をする動きがある。今後、経営層は自社製品やサービスが、それらガイドラインに沿っているかはもちろん、取引先やパートナー企業などが準拠できているかも気にかける必要がある。

日本では経済産業省が2018年6月に「AI・データの利用に関する契約ガイドライン」を策定した(19年12月に改訂)。これは罰則などを伴わないが、欧州で検討されている「EU AI Act」では多額の賠償金を伴う規制の策定が進んでおり、このような動きもAI倫理を重視することにつながる。

(取材・文/谷川耕一 編集/藤岡 堯)

AIは現実から学習を深める以上、用いるデータによっては、判断にバイアスが入る懸念がある。例えば、人種や性別的に偏りが含まれるデータが利用されれば、導き出される結果にも偏りが生じる。AIを開発・利用する事業者は、バイアスのかかった結果を出さないようにし、AIの判断に対する責任の所在をはっきりさせなければ、信頼を得ることはできない。

AI倫理の問題に対処するために、各国ではガイドラインを公表し規制や統制をする動きがある。今後、経営層は自社製品やサービスが、それらガイドラインに沿っているかはもちろん、取引先やパートナー企業などが準拠できているかも気にかける必要がある。

日本では経済産業省が2018年6月に「AI・データの利用に関する契約ガイドライン」を策定した(19年12月に改訂)。これは罰則などを伴わないが、欧州で検討されている「EU AI Act」では多額の賠償金を伴う規制の策定が進んでおり、このような動きもAI倫理を重視することにつながる。

この記事の続き >>

- 既存サービスの利用を制限 米Microsoft

- ビジネス系リーダーが実践主導へ 米IBMの調査

- 影響の評価方式を開発・無償公開 富士通

続きは「週刊BCN+会員」のみ

ご覧になれます。

(登録無料:所要時間1分程度)

新規会員登録はこちら(登録無料) ログイン会員特典

- 注目のキーパーソンへのインタビューや市場を深掘りした解説・特集など毎週更新される会員限定記事が読み放題!

- メールマガジンを毎日配信(土日祝をのぞく)

- イベント・セミナー情報の告知が可能(登録および更新)

SIerをはじめ、ITベンダーが読者の多くを占める「週刊BCN+」が集客をサポートします。 - 企業向けIT製品の導入事例情報の詳細PDFデータを何件でもダウンロードし放題!…etc…

- 1